Aqui alguns dos assuntos a tratar na escola.

Petr Horava

Progress in Quantum Gravity with Anisotropic Scaling

I will give an overview of the basic concepts in quantum gravity with Lifshitz-type anisotropic scaling, as well as some recent developments in this rapidly developing field. Among the topics discussed are the relationship to the lattice formulation of quantum gravity via causal dynamical triangulations, and the possibility of extending the gauge symmetries of the theory to "nonrelativistic general covariance" which eliminates the scalar graviton polarization and makes the theory at long distances closely reminiscent of general relativity.

John Donoghue

Effective Field Theory and General Relativity

Effective Field Theory is a technique for extracting the predictions from a theory, using only the appropriate interactions and degrees of freedom that occur at low energy. This makes it ideal for quantum General Relativity where we know that GR is the appropriate low energy theory. I will discuss the techniques, applications and limitations of the Effective Field Theory approach.

Steve Carlip

1. Spontaneous Dimensional Reduction?

Several lines of evidence hint that quantum gravity at distances slightly larger than the Planck scale may become effectively two-dimensional. I will summarize the evidence for this "spontaneous dimensional reduction," and suggest a further argument based on the effect of vacuum fluctuations on light cones. If this description proves to be correct, it suggests an interesting relationship between small-scale quantum spacetime and the behavior of cosmologies near a spacelike singularity.

Effective Conformal Descriptions of Black Hole Entropy

It is no longer considered surprising that black holes have temperatures and entropies. What remains surprising, though,is the universality of these thermodynamic properties: their very simple and general form, and the fact that they can be derived from many very different descriptions of the underlying microscopic degrees of freedom. I discuss the proposal that this universality arises from an approximate conformal symmetry, which permits an effective ``conformal dual'' description that is largely independent of the microscopic details.

Andrei Mironov

Supersymmetric gauge theories: integrability and dualities

N=2 supersymmetric gauge theories at low energies are associated with integrable systems. This correspondence can be lifted up to the gauge theories in the graviphoton background, the corresponding integrable systems being quantized, and can be encoded in terms of conformal blocks of 2d conformal field theories. It can be also further extended to various dimenions. In particular, its extension to Chern-Simons theory has much to do with knot theory. A review of all these correspondences will be presented.

Gianluca Calcagni

Field theory on fractal spacetime

We discuss how to construct field theories on spacetime geometries with fractal properties. Based on fractional calculus, we introduce continuous spacetimes whose dimension changes with the scale, and that display discrete symmetries in the ultraviolet and ordinary Poincare' symmetries in the infrared. These theories are generally argued to be power-counting renormalizable under certain assumptions.

Not all the results of fundamental science studies generate technologies, but absolutely all modern technologies are grounded on fundamental science studies

O que vc pode achar aqui..

Neste Blog você encontra um pouco de cultura, um pouco de Matemática, Física, Notícias, Alertas, Lazer, Fotos.

Mostrando postagens com marcador Fisica teorica. Mostrar todas as postagens

Mostrando postagens com marcador Fisica teorica. Mostrar todas as postagens

energia escura como uma força de anti-gravidade

Observações de cerca de 200 mil galáxias resultam no estudo mais completo sobre a energia escura. Os dados endossam ideias de Einstein de que existe uma força no espaço agindo contra a gravidade, embora o físico a tenha postulado com outro universo em mente.

Astrônomos australianos, em parceria com a Nasa – agência espacial dos Estados Unidos –, acabam de anunciar que é muito provável que um tipo de antigravidade, conhecida como energia escura, exista e seja a responsável pela expansão acelerada do universo.

A conclusão é fruto do trabalho de 26 pesquisadores do projeto The WiggleZ Survey que, por cinco anos, vasculharam o céu com o Telescópio Anglo-Australiano à procura de dados sobre a natureza da energia escura, uma espécie de força invisível e misteriosa que responderia por 73% de toda a energia contida no universo.

“Nosso trabalho oferece as melhores provas independentes de que a energia escura é real”, afirma o líder do estudo, o astrônomo Chris Blake, da Universidade Swinburne de Tecnologia, na Austrália. “Einstein estava certo, realmente existe uma força antigravitacional”, ressalta o pesquisador, acrescentando que ela está provocando a expansão acelerada do universo.

Na década de 1910, o físico alemão Albert Einstein (1879-1955) postulou a existência de um tipo de força antigravitacional, mas não foi para provar a expansão do universo. Na verdade, Einstein estava convicto de que o universo era estático. Para isso, era preciso haver uma força que repelia os corpos e se equilibrava com a força da gravidade, fechando as contas para um universo ‘parado’. Assim, ele inseriu em suas equações a antigravidade, batizada em seguida de “constante cosmológica”.

Mesmo com a descoberta de que o universo se expande, feita pelo astrônomo estadunidense Edwin Hubble (1889-1953), em 1929, a antigravidade não foi invalidada, embora tenha sido deixada de lado – o próprio Einstein chegou a dizer que ela havia sido “o maior erro científico de sua vida”.

Anos depois, esse conceito ganhou o nome de energia escura e voltou ao cenário da física com o estudo de um grupo internacional de astrônomos em 1998. Na época, os cientistas descobriram que o universo não só se expandia, mas também o fazia de forma acelerada. Para explicar esse fenômeno, recorreram justamente à força antigravitacional de Einstein.

Olhando para o passado

Para provar o efeito da energia escura, os pesquisadores do The WiggleZ Survey criaram o mais completo mapa tridimensional já feito das galáxias, com a ajuda do satélite Galex, da Nasa. As galáxias observadas estão tão distantes da Terra que a luz que emitem revela uma história de sete bilhões de anos atrás, tempo que os raios luminosos levam para chegar até nós.

Com um espectrógrafo acoplado ao telescópio Anglo-Australiano, os astrônomos capturaram a luz emitida pelas galáxias. Esses dados foram usados para medir a distância entre elas e a velocidade com que se afastam da Terra.

O padrão de distribuição dessas estruturas e a velocidade de distanciamento revelaram que elas estão cada vez mais separadas entre si, o que sustenta a ideia de que há uma energia repelente que atua contra a força de atração da gravidade.

A ilustração mostra como os astrônomos mediram a expansão do universo. A luz emitida pelas galáxias das regiões mais remotas do espaço foi usada para medir as distâncias entre elas e determinar a velocidade com que se afastam umas das outras. (imagem: R. Hurt/ Nasa - JPL-Caltech)Os pesquisadores verificaram que os resultados obtidos coincidem com o modelo cosmológico clássico que incorpora a energia escura.

“Embora a gente ainda não conheça a origem da energia escura e o porquê de ela preencher o espaço, nosso trabalho motiva novos esforços de compreensão desse material”, afirma Blake.

Mesmo com o grande esforço e entusiasmo dos pesquisadores, que coletaram uma quantidade de dados sem precedentes, ainda não é possível afirmar categoricamente que a energia escura é real. Segundo o próprio astrônomo líder do estudo, é admissível que fatores como a poeira estelar tenham afetado os resultados da análise da luz emitida pelas galáxias.

De qualquer forma, o trabalho de Blake não termina por aqui. O pesquisador e sua equipe planejam continuar o mapeamento do universo até chegar a evidências da época de sua origem, há aproximadamente 13 bilhões de anos.

Segundo o astrônomo, o estudo da energia escura pode ainda ajudar a desvendar um dos grandes mistérios da física, que tenta explicar por que a mecânica quântica pode ser usada para descrever as quatro forças conhecidas – nuclear forte e fraca, eletromagnética e gravitacional –, exceto a última.

“O que há de errado com a gravidade?”, indaga. “Nós não sabemos, mas uma pista pode estar na observação da energia escura.”

fonte(ciencia hoje)

Astrônomos australianos, em parceria com a Nasa – agência espacial dos Estados Unidos –, acabam de anunciar que é muito provável que um tipo de antigravidade, conhecida como energia escura, exista e seja a responsável pela expansão acelerada do universo.

A conclusão é fruto do trabalho de 26 pesquisadores do projeto The WiggleZ Survey que, por cinco anos, vasculharam o céu com o Telescópio Anglo-Australiano à procura de dados sobre a natureza da energia escura, uma espécie de força invisível e misteriosa que responderia por 73% de toda a energia contida no universo.

“Nosso trabalho oferece as melhores provas independentes de que a energia escura é real”, afirma o líder do estudo, o astrônomo Chris Blake, da Universidade Swinburne de Tecnologia, na Austrália. “Einstein estava certo, realmente existe uma força antigravitacional”, ressalta o pesquisador, acrescentando que ela está provocando a expansão acelerada do universo.

Na década de 1910, o físico alemão Albert Einstein (1879-1955) postulou a existência de um tipo de força antigravitacional, mas não foi para provar a expansão do universo. Na verdade, Einstein estava convicto de que o universo era estático. Para isso, era preciso haver uma força que repelia os corpos e se equilibrava com a força da gravidade, fechando as contas para um universo ‘parado’. Assim, ele inseriu em suas equações a antigravidade, batizada em seguida de “constante cosmológica”.

Mesmo com a descoberta de que o universo se expande, feita pelo astrônomo estadunidense Edwin Hubble (1889-1953), em 1929, a antigravidade não foi invalidada, embora tenha sido deixada de lado – o próprio Einstein chegou a dizer que ela havia sido “o maior erro científico de sua vida”.

Anos depois, esse conceito ganhou o nome de energia escura e voltou ao cenário da física com o estudo de um grupo internacional de astrônomos em 1998. Na época, os cientistas descobriram que o universo não só se expandia, mas também o fazia de forma acelerada. Para explicar esse fenômeno, recorreram justamente à força antigravitacional de Einstein.

Olhando para o passado

Para provar o efeito da energia escura, os pesquisadores do The WiggleZ Survey criaram o mais completo mapa tridimensional já feito das galáxias, com a ajuda do satélite Galex, da Nasa. As galáxias observadas estão tão distantes da Terra que a luz que emitem revela uma história de sete bilhões de anos atrás, tempo que os raios luminosos levam para chegar até nós.

Com um espectrógrafo acoplado ao telescópio Anglo-Australiano, os astrônomos capturaram a luz emitida pelas galáxias. Esses dados foram usados para medir a distância entre elas e a velocidade com que se afastam da Terra.

O padrão de distribuição dessas estruturas e a velocidade de distanciamento revelaram que elas estão cada vez mais separadas entre si, o que sustenta a ideia de que há uma energia repelente que atua contra a força de atração da gravidade.

A ilustração mostra como os astrônomos mediram a expansão do universo. A luz emitida pelas galáxias das regiões mais remotas do espaço foi usada para medir as distâncias entre elas e determinar a velocidade com que se afastam umas das outras. (imagem: R. Hurt/ Nasa - JPL-Caltech)Os pesquisadores verificaram que os resultados obtidos coincidem com o modelo cosmológico clássico que incorpora a energia escura.

“Embora a gente ainda não conheça a origem da energia escura e o porquê de ela preencher o espaço, nosso trabalho motiva novos esforços de compreensão desse material”, afirma Blake.

Mesmo com o grande esforço e entusiasmo dos pesquisadores, que coletaram uma quantidade de dados sem precedentes, ainda não é possível afirmar categoricamente que a energia escura é real. Segundo o próprio astrônomo líder do estudo, é admissível que fatores como a poeira estelar tenham afetado os resultados da análise da luz emitida pelas galáxias.

De qualquer forma, o trabalho de Blake não termina por aqui. O pesquisador e sua equipe planejam continuar o mapeamento do universo até chegar a evidências da época de sua origem, há aproximadamente 13 bilhões de anos.

Segundo o astrônomo, o estudo da energia escura pode ainda ajudar a desvendar um dos grandes mistérios da física, que tenta explicar por que a mecânica quântica pode ser usada para descrever as quatro forças conhecidas – nuclear forte e fraca, eletromagnética e gravitacional –, exceto a última.

“O que há de errado com a gravidade?”, indaga. “Nós não sabemos, mas uma pista pode estar na observação da energia escura.”

fonte(ciencia hoje)

Cientistas do Cern anunciam ter encontrado pistas para a localização do bóson de Higgs

Usando amostras de dados de colisões de prótons coletados até o final de 2011 por meio do Grande Colisor de Hádrons e dos dois principais projetores do Cern, denominados Atlas e CMS, os pesquisadores conseguiram excluir a hipótese da existência do bóson de Higgs em uma ampla gama de possíveis valores para as massas da partícula. Com isso, “as buscas” pelo bóson de Higgs poderão passar a ser concentradas agora em uma região de massa muito menor.

“Os resultados são muito animadores. Agora há uma pequena região onde é possível o bóson de Higgs estar localizado. Porém, é preciso ter cautela, porque os resultados ainda não são conclusivos”, disse Sérgio Novaes, professor da Universidade Estadual Paulista (Unesp), à Agência FAPESP.

Novaes é membro de um dos dois grupos de cientistas que procuram pelo bóson de Higgs no Cern, o Compact Muon Solenoid (CMS), e coordenador do projeto temático Sprace, realizado com apoio da FAPESP.

Por meio do projeto Sprace, os pesquisadores brasileiros operam uma rede de processamento de dados e participam da análise de dados produzidos pelo CMS.

“Nós temos diversos estudantes realizando pesquisas de mestrado e doutorado no Cern. A nossa ideia, agora, é começar a participar de uma forma mais consistente na parte de hardware do CMS e ampliar a nossa participação no experimento como um todo”, disse Novaes.

Usando a amostra de dados de colisões de prótons coletadas até agora no Cern, os pesquisadores do grupo CMS anunciaram hoje que, se o bóson de Higgs existir, há 95% de chances de ele não ser encontrado no intervalo de massa entre 127 e 600 GeV (gigaelétron-volt, termo utilizado na física para quantificar os campos de energia das partículas), e que os maiores indícios da localização da partícula estão na faixa de massa entre 115 e 127 GeV.

Resultados similares ao do CMS foram obtidos pelo grupo Atlas. Trabalhando de forma totalmente independente do CMS, sem nenhuma forma de interação entre os grupos, os cientistas do Atlas excluíram a possibilidade de encontrar o bóson de Higgs entre partículas com massa entre 141 e 476 GeV e indicaram que a partícula pode ter massa entre 116 e 130 GeV.

“É absolutamente surpreendente que dois experimentos realizados de forma independente, sem um grupo ter acesso aos dados do outro, chegarem a resultados tão similares”, avaliou Novaes.

Agora, os dois grupos de pesquisa deverão publicar seus resultados e, posteriormente, se reunirem para combinarem seus dados.

Segundo as estimativas dos pesquisadores do Cern, só será possível estabelecer claramente a existência ou não do bóson de Higgs na região de massa delimitada pelos grupos CMS e Atlas no final de 2012, quando um maior número de amostras de dados de colisões de prótons será coletado.

De acordo com eles, para se chegar a uma conclusão sólida, é preciso dispor de, pelo menos, o dobro de dados de que possuem até o momento.

“A questão agora é segurar só mais um pouco a ansiedade, que vem se acumulando durante os últimos 45 anos, para provar ou não a existência do bóson Higgs. Eu acho que a resposta final está próxima”, disse Novaes.

A partícula foi postulada em 1964 pelo britânico Peter Higgs, que propôs juntamente com outros diversos físicos um mecanismo teórico que tornaria possível que as partículas tivessem massa.

Posteriormente, em 1967, o mecanismo teórico foi incorporado pelo físico norte-americano Steven Weinberg em uma teoria para explicar as partículas elementares do Universo, denominada Modelo-Padrão. Segundo essa tese, o universo foi resfriado após o Big Bang, quando uma força invisível, conhecida como Campo de Higgs, formou-se junto de partículas associadas, os bósons de Higgs, transferindo massa para outras partículas fundamentais.

Desde o lançamento da teoria, os cientistas vêm buscando descobrir a partícula, cujos sinais da presença dela são extraídos de uma grande quantidade de dados similares e a partir da produção de um grande número de eventos para se certificar da descoberta.

“É como tentar encontrar, literalmente, uma agulha no palheiro. É extremamente complexo extrair o sinal da existência da partícula de bóson Higgs”, disse Novaes.

De acordo com ele, a busca pela partícula só está sendo possível ser realizada graças ao desenvolvimento de novas tecnologias por cientistas e engenheiros de diversas instituições de pesquisa em todo mundo, que estão se propagando para outras áreas do conhecimento, como a medicina e a computação.

referencia: agencia fapesp

Descoberta conexão surpreendente entre fenômenos quânticos

Conexões quânticas

Dois pesquisadores descobriram uma conexão inesperada e surpreendente entre as duas propriedades fundamentais da física quântica.

O resultado está sendo anunciado como um avanço radical no entendimento da mecânica quântica, dando novas pistas para os cientistas que procuram compreender os fundamentos do funcionamento do mundo em escala atômica.

Stephanie Wehner, da Universidade Nacional de Cingapura, e Jonathan Oppenheim, da Universidade de Cambridge, descobriram uma ligação entre a chamada "ação fantasmagórica à distância" e o Princípio da Incerteza de Heisenberg.

O comportamento absolutamente estranho das partículas quânticas - como átomos, elétrons e fótons - tem intrigado os cientistas há quase um século. Albert Einstein foi um dos que acharam que o mundo quântico era tão estranho que a teoria quântica devia estar errada.

Mas a realidade mostrou o contrário, e experimento após experimento têm confirmado as previsões da teoria.

Fantasmas e incerteza

Um dos aspectos mais estranhos da teoria quântica é que é impossível saber certas coisas simultaneamente, como o momento e a posição de uma partícula - conhecer uma dessas propriedades afeta a precisão com que você pode conhecer a outra.

Isto é conhecido como o Princípio da Incerteza de Heisenberg, em homenagem ao físico alemão Werner Heisenberg, que o enunciou nos anos 1920.

Outro aspecto estranho é o fenômeno da não-localidade, que se mostra no bem conhecido entrelaçamento quântico.

Quando duas partículas ficam entrelaçadas, elas se comportam como se estivessem coordenadas entre si, como se estivessem "trocando informações" à distância, de uma forma totalmente estranha à intuição clássica sobre partículas fisicamente separadas.

Até agora, os pesquisadores vinham tratando a não-localidade e a incerteza como dois fenômenos distintos.

Mas Wehner e Oppenheim mostraram que eles estão intrinsecamente ligados.

Mais do que isso, eles demonstraram que esta ligação é quantitativa, e elaboraram uma equação que mostra que a "quantidade" de não-localidade é determinada pelo princípio da incerteza.

"É uma reviravolta surpreendente e talvez irônica", disse Oppenheim. Einstein e seus colaboradores descobriram a não-localidade quando procuravam uma maneira de se livrar do princípio da incerteza. "Agora o princípio da incerteza parece estar dando o troco."

Não-localidade

A não-localidade determina como duas partículas distantes podem coordenar suas ações sem trocar informações.

Os físicos acreditam que, mesmo na mecânica quântica, a informação não pode viajar mais rápido do que a luz.

Acontece que a mecânica quântica permite que duas partículas se coordenem muito melhor do que seria possível se elas obedecessem às leis da física clássica.

Na verdade, as ações das partículas entrelaçadas são de tal maneira coordenadas que parece que uma é capaz de falar com a outra. Foi por isto que Einstein chamou esse fenômeno de "ação fantasmagórica à distância".

E isso não é tudo. Os fantasmas podem ser ainda mais assustadores, porque é possível ter teorias que permitem que partículas separadas e distantes uma da outra coordenem suas ações muito melhor do que a natureza permite - e sem depender de que a informação viaje mais rápido do que a luz.

Limite da esquisitice

O que os dois pesquisadores agora descobriram é que parece haver um limite para essas esquisitices da teoria quântica.

"A teoria quântica é mesmo muito estranha, mas não é tão estranha quanto poderia ser. Nós realmente temos que nos perguntar, o que limita a mecânica quântica? Por que a natureza não permite uma não-localidade ainda mais forte?" pondera Oppenheim.

A resposta que ele e Wehner encontraram está justamente no princípio da incerteza.

Duas partículas só podem coordenar suas ações de forma mais eficiente se quebrarem o princípio da incerteza, que na verdade impõe um limite estrito à intensidade da não-localidade.

"Seria ótimo se pudéssemos coordenar melhor nossas ações a longas distâncias, o que nos permitiria resolver muitas tarefas no processamento de informações de forma muito eficiente," diz Wehner. "No entanto, a física deveria ser fundamentalmente diferente. Se quebrarmos o princípio da incerteza, não podemos imaginar como o nosso mundo seria."

Vendo as coisas de outro modo

E como eles descobriram uma ligação que passou despercebida por tanto tempo?

Wehner começou sua carreira como "hacker de computador", fazendo "serviços sob encomenda". Agora ela trabalha com teoria da informação quântica. Já Oppenheim é físico.

Wehner acredita que a aplicação das técnicas da ciência da computação às leis da física teórica foi fundamental para detectar a conexão.

"Eu acho que uma das idéias fundamentais foi vincular a questão a um problema de programação," diz Wehner. "As formas tradicionais de ver a não-localidade e a incerteza obscureciam a estreita ligação entre os dois conceitos."

Jogo de tabuleiro quântico

Imagine um jogo de tabuleiro quântico, jogado por dois parceiros, Alice e Bob. O tabuleiro tem apenas dois quadrados, nos quais Alice pode colocar um contador de duas cores possíveis: verde ou rosa. Ela foi instruída a colocar a mesma cor nos dois quadrados, ou colocar uma cor diferente em cada quadrado.

Bob tem que adivinhar a cor que Alice colocar no primeiro ou no segundo quadrado. Se o seu palpite estiver correto, Alice e Bob ganham o jogo.

Dessa forma, Alice e Bob vão sempre ganhar o jogo se puderem falar um com o outro: Alice simplesmente diz a Bob quais cores estão nas casas um e dois.

Mas Bob e Alice estão situados tão distantes um do outro que a luz - portanto, qualquer sinal de transmissão de dados - não tem tempo para trafegar entre eles durante o jogo.

Se eles não podem se falar, não vão ganhar sempre.

Mas, através da medição das partículas quânticas, eles poderão ganhar o jogo mais vezes do que qualquer estratégia que não dependa da teoria quântica.

No entanto, o princípio de incerteza os impede de se sair melhor do que isso, e ainda determina a frequência com que eles vão perder o jogo.

Princípio da física quântica

A descoberta traz de volta a questão mais profunda de quais princípios estão subjacentes à física quântica.

Várias tentativas de compreender os fundamentos da mecânica quântica têm-se centrado na não-localidade.

Wehner acredita que pode ser mais interessante examinar os detalhes do princípio da incerteza. "Entretanto, nós mal arranhamos a superfície do entendimento das relações de incerteza", diz ela.

Segundo os pesquisadores, sua descoberta é "à prova de futuro" e se aplica a todas as teorias que buscam encontrar uma teoria quântica da gravidade.

Bibliografia:

The Uncertainty Principle Determines the Nonlocality of Quantum Mechanics

Jonathan Oppenheim, Stephanie Wehner

Science

19 November 2010

Vol.: 330 pp 1072-1074

DOI: 10.1126/science.1192065

http://arxiv.org/abs/1004.2507 (versão livre)

Dois pesquisadores descobriram uma conexão inesperada e surpreendente entre as duas propriedades fundamentais da física quântica.

O resultado está sendo anunciado como um avanço radical no entendimento da mecânica quântica, dando novas pistas para os cientistas que procuram compreender os fundamentos do funcionamento do mundo em escala atômica.

Stephanie Wehner, da Universidade Nacional de Cingapura, e Jonathan Oppenheim, da Universidade de Cambridge, descobriram uma ligação entre a chamada "ação fantasmagórica à distância" e o Princípio da Incerteza de Heisenberg.

O comportamento absolutamente estranho das partículas quânticas - como átomos, elétrons e fótons - tem intrigado os cientistas há quase um século. Albert Einstein foi um dos que acharam que o mundo quântico era tão estranho que a teoria quântica devia estar errada.

Mas a realidade mostrou o contrário, e experimento após experimento têm confirmado as previsões da teoria.

Fantasmas e incerteza

Um dos aspectos mais estranhos da teoria quântica é que é impossível saber certas coisas simultaneamente, como o momento e a posição de uma partícula - conhecer uma dessas propriedades afeta a precisão com que você pode conhecer a outra.

Isto é conhecido como o Princípio da Incerteza de Heisenberg, em homenagem ao físico alemão Werner Heisenberg, que o enunciou nos anos 1920.

Outro aspecto estranho é o fenômeno da não-localidade, que se mostra no bem conhecido entrelaçamento quântico.

Quando duas partículas ficam entrelaçadas, elas se comportam como se estivessem coordenadas entre si, como se estivessem "trocando informações" à distância, de uma forma totalmente estranha à intuição clássica sobre partículas fisicamente separadas.

Até agora, os pesquisadores vinham tratando a não-localidade e a incerteza como dois fenômenos distintos.

Mas Wehner e Oppenheim mostraram que eles estão intrinsecamente ligados.

Mais do que isso, eles demonstraram que esta ligação é quantitativa, e elaboraram uma equação que mostra que a "quantidade" de não-localidade é determinada pelo princípio da incerteza.

"É uma reviravolta surpreendente e talvez irônica", disse Oppenheim. Einstein e seus colaboradores descobriram a não-localidade quando procuravam uma maneira de se livrar do princípio da incerteza. "Agora o princípio da incerteza parece estar dando o troco."

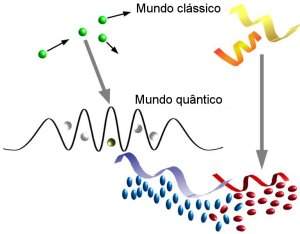

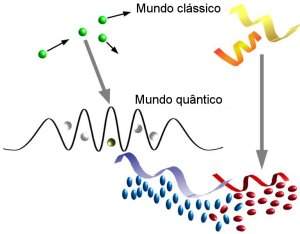

Em 2007, cientistas realizaram um experimento que demonstrou a que os átomos assombrados de Einstein eram reais, o que representou um avanço para a computação quântica. [Imagem: UMichigan]

A não-localidade determina como duas partículas distantes podem coordenar suas ações sem trocar informações.

Os físicos acreditam que, mesmo na mecânica quântica, a informação não pode viajar mais rápido do que a luz.

Acontece que a mecânica quântica permite que duas partículas se coordenem muito melhor do que seria possível se elas obedecessem às leis da física clássica.

Na verdade, as ações das partículas entrelaçadas são de tal maneira coordenadas que parece que uma é capaz de falar com a outra. Foi por isto que Einstein chamou esse fenômeno de "ação fantasmagórica à distância".

E isso não é tudo. Os fantasmas podem ser ainda mais assustadores, porque é possível ter teorias que permitem que partículas separadas e distantes uma da outra coordenem suas ações muito melhor do que a natureza permite - e sem depender de que a informação viaje mais rápido do que a luz.

Limite da esquisitice

O que os dois pesquisadores agora descobriram é que parece haver um limite para essas esquisitices da teoria quântica.

"A teoria quântica é mesmo muito estranha, mas não é tão estranha quanto poderia ser. Nós realmente temos que nos perguntar, o que limita a mecânica quântica? Por que a natureza não permite uma não-localidade ainda mais forte?" pondera Oppenheim.

A resposta que ele e Wehner encontraram está justamente no princípio da incerteza.

Duas partículas só podem coordenar suas ações de forma mais eficiente se quebrarem o princípio da incerteza, que na verdade impõe um limite estrito à intensidade da não-localidade.

"Seria ótimo se pudéssemos coordenar melhor nossas ações a longas distâncias, o que nos permitiria resolver muitas tarefas no processamento de informações de forma muito eficiente," diz Wehner. "No entanto, a física deveria ser fundamentalmente diferente. Se quebrarmos o princípio da incerteza, não podemos imaginar como o nosso mundo seria."

Vendo as coisas de outro modo

E como eles descobriram uma ligação que passou despercebida por tanto tempo?

Wehner começou sua carreira como "hacker de computador", fazendo "serviços sob encomenda". Agora ela trabalha com teoria da informação quântica. Já Oppenheim é físico.

Wehner acredita que a aplicação das técnicas da ciência da computação às leis da física teórica foi fundamental para detectar a conexão.

"Eu acho que uma das idéias fundamentais foi vincular a questão a um problema de programação," diz Wehner. "As formas tradicionais de ver a não-localidade e a incerteza obscureciam a estreita ligação entre os dois conceitos."

O comportamento absolutamente estranho das partículas quânticas - como átomos, elétrons e fótons - tem intrigado os cientistas há quase um século. [Imagem: Adaptado de Chanchicto/Wikimedia]

Imagine um jogo de tabuleiro quântico, jogado por dois parceiros, Alice e Bob. O tabuleiro tem apenas dois quadrados, nos quais Alice pode colocar um contador de duas cores possíveis: verde ou rosa. Ela foi instruída a colocar a mesma cor nos dois quadrados, ou colocar uma cor diferente em cada quadrado.

Bob tem que adivinhar a cor que Alice colocar no primeiro ou no segundo quadrado. Se o seu palpite estiver correto, Alice e Bob ganham o jogo.

Dessa forma, Alice e Bob vão sempre ganhar o jogo se puderem falar um com o outro: Alice simplesmente diz a Bob quais cores estão nas casas um e dois.

Mas Bob e Alice estão situados tão distantes um do outro que a luz - portanto, qualquer sinal de transmissão de dados - não tem tempo para trafegar entre eles durante o jogo.

Se eles não podem se falar, não vão ganhar sempre.

Mas, através da medição das partículas quânticas, eles poderão ganhar o jogo mais vezes do que qualquer estratégia que não dependa da teoria quântica.

No entanto, o princípio de incerteza os impede de se sair melhor do que isso, e ainda determina a frequência com que eles vão perder o jogo.

Princípio da física quântica

A descoberta traz de volta a questão mais profunda de quais princípios estão subjacentes à física quântica.

Várias tentativas de compreender os fundamentos da mecânica quântica têm-se centrado na não-localidade.

Wehner acredita que pode ser mais interessante examinar os detalhes do princípio da incerteza. "Entretanto, nós mal arranhamos a superfície do entendimento das relações de incerteza", diz ela.

Segundo os pesquisadores, sua descoberta é "à prova de futuro" e se aplica a todas as teorias que buscam encontrar uma teoria quântica da gravidade.

Bibliografia:

The Uncertainty Principle Determines the Nonlocality of Quantum Mechanics

Jonathan Oppenheim, Stephanie Wehner

Science

19 November 2010

Vol.: 330 pp 1072-1074

DOI: 10.1126/science.1192065

http://arxiv.org/abs/1004.2507 (versão livre)

Buracos negros nao existem?

Uma equipe de cientistas (Tanmay Vachaspati et. al.) publicaram um artigo no Physical Review D, onde afirman que quando colapsa uma estrela o horizonte de eventos nunca se chega a formar. Como sabemos o carateriztica principal de um buraco negro é justamente a existencia do seu horizonte de eventos, com dimensões deste horizonte definida pela massa da estrela. Porem segundo estes pesquisadores, ela nunca chega a se formar, no lugar existiria uma radiação do tipo "radiação de Hawking" que faria se dissipar antes de se formar o horizonte de eventos. Segundo os pesquisadores este escenario é para um observador longe da estrela em colapso. Eles afirman que durante o colapso o buraco negro perde mais rapido a massa que o que ganha pelo colapso, por tanto nao tem formação do horizonte de eventos. Inclusive pelo dito anteriormente nao teria perda de informação e nehum tipo de paradoxo de informação que tanto deixou de cabelos em pe aos cosmologos e astrofisicos. os fisicos teoricos estao numa discussao danada.

Fisicos teóricos predicen próximo ciclo solar débil

Existen registros que en la antiguedad los chinos ya observaron variaciones en la presencia de manchas solares. En el lado occidental, existe noticias que un aficionado llamado Heinrich Schwabe fue el primero que se dio cuenta en 1843 de que las manchas parecían presentar un período de unos 10 años, lo que fue confirmado en 1855 por Rudolph Wolf quien halló una periodicidad de 11 años, el conocido ciclo undecenal solar. Posteriormente desde los años 1950 ya se sabia que el sol (nuestra estrella mas próxima), realmente tiene una actividad nuclear intensa, además, sufre alteraciones en su actividad, esto es en la presencia de manchas solares, emisión de radiación e intensidad del campo magnético, etc. En particular, se sabe que cuando el numero de manchas solares es máximo la luminosidad del sol también lo es. Inclusive este aumento en la actividad solar permite mayor presencia de partículas cargadas en la tierra provenientes del sol, generando interferencia en las transmisiones de radio y TV,al mismo tiempo se puede ver mayor intensidad luminosidad e intensidad en las auroras boreales. Se sabe que el campo magnético terreaste sufre alteraciones al interactuar con el campo magnético solar, además, este ciclo solar influye también en el clima de la tierra. Ya en los años 80 existía noticias de investigaciones hechas en el numero de accidentes de transito, que supuestamente tenían un máximo de ocurrencia curiosamente cada 11 años, coincidiendo con el periodo del ciclo solar. Este resultado del todo no es descabellado, puesto que una mayor presencia departículas cargadas atravesando nuestro cerebro podría eventualmente perjudicar nuestra capacidad de responder rápidamente a determinadas situaciones.

Físicos de China e India pronosticaron que el próximo ciclo en la actividad solar que debe comenzar el 2011, debe ser mas suave, esto es, la emisión de radiación magnética y partículas cargadas serán menos intensas, esto disminuirá los efectos adversos en las transmisiones vía satélite, por ejemplo. Existe evidencia de que existe correlación entre el valor del campo magnético en los extremos del ciclo y la intensidad total del ciclo siguiente, con esta premisa, se podría predecir la intensidad de ciclos futuros usando los datos pasados. Por el hecho que la intensidad del campo magnético polar es bajo en el ciclo actual, se prevee que en los 100 años próximos el ciclo solar será de baja intensidad.Según el nuevo modelo teórico de los científicos, se pronostica que el ciclo solar próximo ( ciclo 24) será 35 % mas débil que el ciclo anterior (23, actual).

Primera foto: Una mancha solar, lugar donde la temperatura es más baja que en en resto del sol y con una intensa actividad magnética.

Assinar:

Postagens (Atom)